메타 ‘라마3’ 오픈소스 모델 공개, LLM에서 SLM까지 가열되는 ‘AI 경쟁’

오픈AI·구글·메타 등 초거대 AI 기술시장에서 격돌

최근 효율적인 SLM 기반의 초경량 오픈모델 각광

韓 파운데이션 모델 '0건', SLM 고도화 주력해야

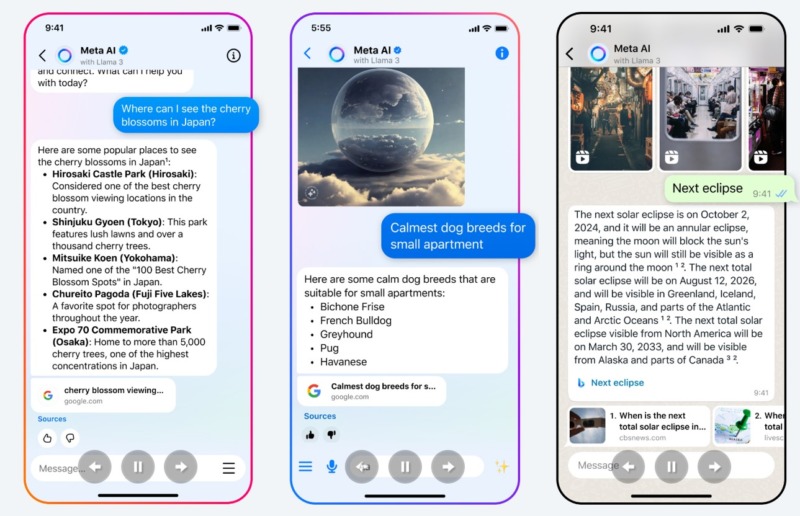

메타가 대규모 언어모델(LLM) ‘라마3(Llama 3)’를 오픈소스로 공개하고 페이스북과 인스타그램, 왓츠앱 등 자사 소셜미디어(SNS)에 적용한다고 밝혔다. 앞서 구글과 오픈AI도 각각 ‘제미나이 프로 1.5’, ‘소라’ 등을 공개하면서 초거대 AI 시장에서의 경쟁이 치열해지고 있다. 여기에 효율화·최적화를 앞세운 소형언어모델(SLM)이 빠르게 확산되면서 미스트랄, 팰컨 등 해외 테크 기업들이 미국의 빅테크 기업들 사이에서 돌파구를 모색하고 있다.

차세대 LLM ‘라마3’ 오픈소스 공개, 페이스북 등 SNS에 탑재

19일(현지시간) 메타는 자체 개발한 차세대 LLM 라마3를 오픈소스로 공개했다. 메타는 “라마3는 추론, 코드 생성, 지시 수행에 있어 라마2보다 성능이 개선됐다”며 “두 모델 모두 다중작업언어이해(MMLU) 테스트에서 구글의 ‘제미나이 프로 1.0’을 앞섰다”고 강조했다.

메타는 사전훈련과 미세조정을 마친 매개변수 80억 개(8B)와 700억 개(70B) 모델 두 가지를 공개했는데 현재 개발 중인 매개변수 4,000억 개 모델도 추후 오픈소스로 공개할 계획이라고 밝혔다. 현시점 LLM의 선두주자인 오픈AI의 GPT-4의 경우, 매개변수가 1조5,000억 개로 추정된다.

메타에 따르면 라마3는 사전훈련과 사후훈련 과정을 고도화해 성능을 향상했다. 일상적인 질문부터 과학·기술·공학·수학(STEM) 분야와 코딩에 이르는 다양한 데이터셋 중 필터링을 거친 고품질 데이터만을 선별해 적용했다. 여기에 전문가와 자동화된 도구를 활용한 레드팀 훈련을 통해 부적절한 답변 가능성을 최소화하는 ‘지시 미세조정’ 과정을 거쳤다.

아울러 메타는 이날 SNS 플랫폼용 챗봇 ‘메타AI’도 공개했다. 라마3 기반으로 만들어진 메타AI는 페이스북, 인스타그램 등에 내장돼 사용자 질문에 답하고 이미지를 생성할 수 있다.

기억력 추가한 챗GPT, 멀티모달 AI 소라 등 초거대 AI 진화

AI 기술력은 오픈AI와 구글을 중심으로 한 빅테크 기업들의 경쟁이 격화되면서 빠르게 고도화되고 있다. 앞서 지난 2월 13일(현지시간) 오픈AI는 블로그를 통해 “챗GPT에 기억력을 추가해 테스트 중”이라면서 “소수 사용자에게 우선 선보인 뒤 확대 적용하겠다”고 밝혔다. 오픈AI에 따르면 새 기능이 적용된 챗GPT는 사용자와의 과거 대화를 기억해 반복적인 답변 없이 보다 정확하고 새로운 정보를 제공한다.

이어 이틀 후인 2월 15일에는 구글이 ‘제미나이 1.5 프로’를 공개했다. 최상위 모델 ‘울트라 1.0’을 공개한 지 일주일 만에 프로의 업데이트 버전을 공개한 것이다. 제미나이 1.5 프로는 한 번에 최대 100만 개의 토큰을 처리할 수 있다. 이는 제미나이 1.0 프로의 3만2,000개, 오픈AI GPT-4 터보의 12만8,000개를 뛰어넘는 현존 최대 수치다.

구글의 새 AI 출시 소식에 오픈AI는 문장을 최대 1분 길이의 동영상으로 만들어주는 멀티모달 AI ‘소라’를 선보이며 맞불을 놨다. 소라는 여러 캐릭터와 특정한 동작, 복잡한 장면 등을 이해하고 생생한 영상을 만들어준다. 기존에도 문장이나 사진을 영상으로 만들어주는 AI 모델은 있었지만 소라는 명령어의 맥락을 파악해 지시한 내용이 물리적인 세계에서 어떻게 존재하는지 이해함으로써 생생한 감정 표현과 캐릭터, 세상을 생성할 수 있다.

구글, 제미나이와 같은 기술로 구축한 초경량 오픈 모델 공개

이런 가운데 최근 들어서는 챗GPT 등 대규모 컴퓨팅 자원을 소모하며 ‘양’으로 승부하는 LLM와 함께 ‘질’로 경쟁하는 소형언어모델(SLM)의 출시도 이어지고 있다. 일각에서는 생성형 AI 개발 트렌드가 ‘규모’의 경쟁에서 소형화·최적화로 옮겨가고 있다는 평가도 나온다. 그도 그럴 것이 초거대 AI는 개발과 구동에 대량의 그래픽처리장치(GPU)가 요구되고 전력 소모가 많아 거대한 자본을 필요로 한다. 몸집이 큰 만큼 사용처에 맞게 최적화하는 데도 한계가 있다. 실생활 곳곳에 녹아들기에는 지나치게 무겁고 비싸 가격 대비 성능이 좋지 않은 셈이다.

빅테크 기업들이 SLM에 주목하는 이유도 여기에 있다. SLM은 소형 AI와 온디바이스AI의 확산에 따라 사용 환경에 적합한 성능과 비용의 AI를 제공하는 한편 초거대 AI로 쏠리는 연산 부담 또한 분산시킬 수 있다. 일반적으로 매개변수 300억 개를 LLM과 SLM을 구분하는 기준점으로 보는데 최근 출시되는 대다수 생성형 AI의 매개변수는18억~70억 개 선이다.

이처럼 효율적인 생성형 AI 개발이 하나의 거대한 트렌드가 돼가고 있는 가운데 메타는 일찌감치 매개변수 70억 개의 ‘라마-7B’를 출시한 바 있다. 구글도 매개변수 18억 개와 32억5,000만 개로 이뤄진 ‘제미나이 나노’를 함께 선보이며 SLM 대열에 합류했고, 마이크로소프트(MS)의 ‘파이-2’와 애플의 ‘패럿’도 각각 매개변수 27억 개, 70억개의 SLM이다.

소형 AI 개발 붐의 배경에는 초거대 AI의 주도권을 이미 미국의 빅테크 기업들이 거머쥐었다는 현실 인식도 작용한 것으로 나타났다. 실제 초거대 AI 시장은 MS·오픈AI 연합의 챗GPT가 자금력 우위를 바탕으로 주도하고 있어 구글조차 추격이 힘겨운 상황이다. 반면 소형 AI에서는 기술력만 있으면 돌파구를 찾을 수 있다.

최근 고성능 소형 AI로 주목받는 미스트랄, 팰컨, Qwen 등이 각각 프랑스, 아랍에미리트(UAE), 중국에서 개발된 점도 이를 방증한다. 해당 기업들은 AI 소형화뿐만 아니라 설계도인 ‘소스’를 공개해 연합전선을 구축함으로써 돌파구를 모색하고 있다. AI 기술을 독점할 수는 없더라도 개방성을 통해 부족한 자본력과 인력을 극복하겠다는 전략이다.

韓, AI 투자에도 제대로 된 성과 없어, 글로벌 빅테크 종속 우려

하지만 초거대 AI 개발 경쟁을 벌이고 있는 미국의 기업들과 틈새시장으로 SLM을 공략하고 있는 해외 테크 기업들 사이에서 한국의 AI 기술은 여전히 답보 상태에 머물러 있다. 지난 16일 미국 스탠퍼드대 인간중심인공지능연구소(HAI)가 발표한 ‘AI 인덱스 2024’ 보고서에 따르면 지난해 생성형 AI 기술의 기반이 되는 ‘파운데이션 모델’을 개발한 한국 기업은 한 곳도 없었다.

파운데이션 모델을 가장 많이 개발한 국가는 미국으로 109개를 개발했다. 이어 중국 20개, 영국 8개, 아랍에미리트 4개 순이다. 대만, 스위스, 스웨덴 등도 파운데이션 모델 개발에 성공했다.

미국은 고성능 머신러닝 기술 개발에서도 61개로 압도적인 1위를 차지했다. 이어 중국 15개, 프랑스 8개, 독일 5개, 캐나다·이스라엘·영국 4개, 싱가포르 3개 등의 순으로 나타났다. 아랍에미리트와 이집트도 각각 3개와 2개를 개발했지만 역시나 한국은 한 건도 없었다.

이 때문에 업계에서는 한국 IT 생태계가 글로벌 빅테크에 종속될 것이라는 우려의 목소리가 나오고 있다. 국내 빅테크 기업들과 스타트업들도 글로벌 AI 경쟁에 뛰어들면서 일부 기업이 글로벌 상위권 수준의 LLM을 개발했다고 발표하기는 했지만 기반 기술은 해외에서 그대로 들여온 경우가 대부분이기 때문이다. 실제로 카카오뱅크, 뤼이드 등이 개발한 AI가 허깅페이스의 ‘LLM 리더보드’에서 1위에 올랐지만 대부분 메타의 라마2, 미스트랄AI의 미스트랄7B 등 다른 업체 파운데이션 모델을 활용해 자체 기술 수준이 높다고 보기 어렵다.

더 큰 문제는 AI 투자액에 비해 결과가 부실하다는 점이다. 그동안 국내 IT 기업들은 앞다퉈 AI에 거액을 투자했다. AI 인덱스에 따르면 최근 10년간 한국 기업의 AI 투자액은 72억5,000만 달러(약 10조1,202억원)로 세계 9위 수준이다. 그럼에도 성과가 ‘0건’이라는 점은 그동안 국내 기업의 AI 투자가 적재적소에 충분히 투입되지 않았음을 의미한다.

![[빅데이터] 볼커 시절 떠올리게 하는 파월](https://pabii.com/wp-content/uploads/sites/2/2023/11/20221020_2-768x260.jpg)

![[기자수첩] 사우디 국부펀드 PIF, 논란의 투자 사례 분석 ⓛ 네옴시티](https://pabii.com/wp-content/uploads/sites/2/2023/11/사우디-768x432.jpg)

![[빅데이터] 5월 경상수지 흑자는 경제 활동 축소에 따른 착시효과?](https://pabii.com/wp-content/uploads/sites/2/2023/11/2023-07-07-140559-768x449.png)