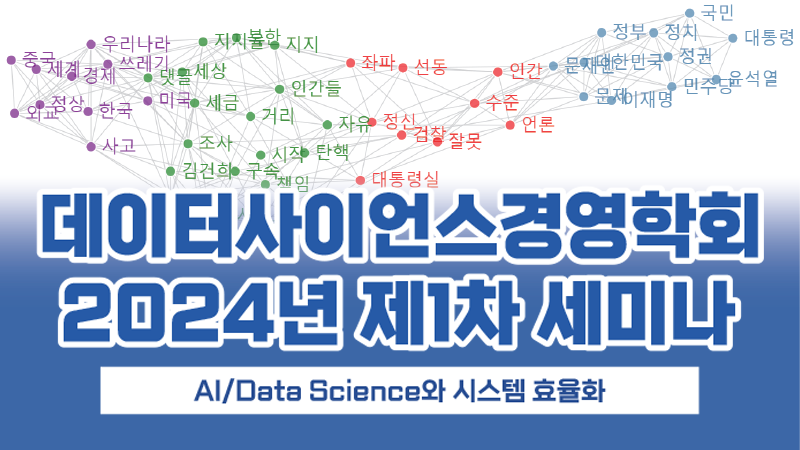

여성차별하는 AI….일까?

아마존(Amazon.com)이 인공지능 인력 채용 프로그램을 폐기했다는 신문 기사가 떴다. 짜놓은 알고리즘을 따라가면 여성 지원자들을 안 뽑는 방식으로 결론이 나온단다.

(Source: Reuters)

저 프로세스에 대한 기술적인 평가나 도덕적인 판단을 내리기 전에, 일반적인 서류 선별 (Resume screening) 작업을 한번 생각해보자.

대학 졸업반 시절에 B 모 전략컨설팅 회사에서 잠깐 인턴을 했던 적이 있다. 그만 둘 날짜가 며칠 안 남은 상황이었는데, 우리 팀 Associate (말단 컨설턴트)이 HR팀 데스크에 잠깐 가서 산더미처럼 쌓여있는 Resume들을 휙휙휙휙휙휙~~~ 손으로 넘겨보더라. 최소한 2, 300장은 쌓여있었던거 같은데, 그 분이 스캔하는 시간은 1분이 채 지나지 않았다. (한 장에 1분이 아니라, 300장 전체에 1분..) 5장 정도를 뽑더니, HR 팀 담당자한테 전화 인터뷰 스케줄 잡아달라고 부탁하는 모습을 봤었다.

뱅킹 일하던 시절에 너무 심하게 개인 소개로 추천 받은 분들 중에서만 인턴을 뽑는 것 같아서 모교 게시판에 한번 Job Posting을 한 적이 있었는데, 정말 하룻밤만에 100명이 넘는 지원 메일을 받았었다.

그런 경험을 미뤄볼 때, Amazon같은 회사가 Job Posting을 하나 올리면, 아무리 요구 스킬을 맞추기 어려워도 1주일 안에 최소 몇 백명이 지원서를 날릴 것이라는데 의구심의 여지가 없다.

저런 Resume들을 하나하나 꼼꼼하게 봐주는게 지원자에 대한 예의겠지만, 다른 한편으로 회사 입장에서도 HR 프로세스를 최대한 효율적으로 해야할 필요가 있다.

이런 상황에서 당신이 오너라면 어떤 결정을 내리겠나? 연봉 15만불을 주고 있는 Associate에게 일하는 시간을 쪼개서 면접 보라고 하는 것도 돈 아까운 판국에, Resume screening 하고 있으라고 하고 싶은가? 면접은 몰라도 Resume screening 만큼은 돈 or 시간을 아끼고 싶은게 당연지사라고 본다. (자본주의 사회니까)

자동화 알고리즘 Recruiter 1 – 영문 이력서의 특징

아마존의 AI Recruiter 프로그램은 그런 이유 때문에 만들어졌을 것이다. 지원자의 Resume에 있는 단어들을 scrapping해서 연봉 협상 단계까지 간 그룹(1)과 면접 중에 탈락했던 그룹(0) 데이터로 or 일 잘해서 내부 성과 평점을 높게 받은 직원 그룹 (1)과 아닌 그룹 (0)으로 정리한 데이터로 모델을 만들었을 것 같다. 단어 처리를 어떻게 했을지는 구체적으로 알 수 없지만, 아마도 중요 단어 or 문장이 resume에 적혀있는지 여부에 따라서 0~1 사이의 특정 점수를 각각의 Resume에 부여했을 것이다. 챗봇도 아니고, Resume에 들어가는 단어의 종류가 많지 않으니 Natural Language Process (NLP) 치고 꽤나 가벼운 모델이었을 것이라고 짐작된다.

참고로, 영어권의 Resume는 우리나라 이력서처럼 생기지 않았다. 어느 직장에서 어떤 Role을 했는지를 쓰는게 아니라, 어떤 Project를 하면서 뭘 배웠고, 무슨 기여를 했는지를 짧은 2-3개 Bullet point로 정리해놓은게 일상이다. 학교 어디나왔다는 이야기 쓸 때도 마찬가지다. 우리나라처럼 X대 Y학과 몇 년도 졸업을 쓰고 끝내는게 아니라, 무슨 specialty로 공부했고, 어떤 부분에 특화된 공부를 했는지, 재학 중에 무슨 Project를 했는지 등등을 쓴다. 모든 걸 다 떠나서 한국처럼 사진 넣은 이력서는 진짜 아무도 안 쓴다 ㅋㅋ (평생 한국말로 이력서를 써 본적이 없어서 pabii 사람 뽑는데 가끔 그런 이력서 받으면 놀란다. 헉~)

우리나라처럼 여학교 출신 인력이 상당수를 차지하는 나라도 아니고, 전공 선택을 하는데 이슬람 국가처럼 남자들이 하는 전공이 따로 있다고 강제하지도 않는다. 그런데도 불구하고 남/녀 차별이 있었다면 그건 순전히 단어와 문장 구성의 차이에서 비롯된 것이라고 봐야한다.

(Source: itakeactions.org)

자동화 알고리즘 Recruiter 2 – 상관관계 vs. 인과관계

자기 Resume에 쓴 단어로 불합격자 or 합격자 스타일이라는 결론을 내리는 것과 성별로 차별하는 것과의 연관관계는 무엇일까? 둘의 상관관계 (Correlation)는 굉장히 높았을지 모른다. 저런 언론 기사를 보면 꽤나 높았나보다. 근데, 상관관계와 별개로 내가 선택한 단어와 성별간의 인과관계 (Causation)는 없어야 한다. 남녀간 능력의 차이가 없다면 말이다.

우리나라 사람들이 유학갈 때 유학원의 도움을 받은 Essay를 보면 천편일률적이고 비슷한 단어들 판박이다. 그런데 영어권에서는 그런 Cookie-cutter essay (틀에 박힌 구조의 에세이)를 심한경우에는 표절(Plagiarism)로 생각한다. 그런 문화권에서는 자기 이력서는 당연히 자기가 작성하고, 자기만의 스타일이 녹아날 수 밖에 없다.

자기 스타일이 녹아들어가 있는 이력서가 Amazon 기준에서 합격자들 스타일이 아니라고 판단을 내리는건데, 여성이 대부분 배제되었다는 이유로 여성 차별로 몰고 갈 수 있을까?

내가 이력서에 선택한 단어와 문장 구조는 내 능력을 보여주는 지표 중 하나다. 내 성별을 보여주는 지표가 아니라.

결과적으로 여성 인력이 배제되었다는 이유로 모델링 과정에서 여성을 차별했다고 판단해서는 안 된다.

자동화 알고리즘 Recruiter 3 – 데이터 Feeding / Classification

국X일보 사설에서 “여성차별하는 AI”라고 지적하신 분은 Amazon이 남성 인력을 잔뜩 보유한 회사이기 때문에, IT업계에 남성 인력이 압도적으로 많기 때문에, 그런 데이터만 이용해서 모델을 만들면 당연히 저런 결론이 나온다고 하셨다.

저 가정에 대한 대답을 하기 전에, IT회사들 인력 상황을 간단하게 살펴보자. IT업 특성상 “개발자”라고 불리는 직군의 비중이 크다. 어느 회사를 가나 개발 직군에 있는 여성 인력을 만나기는 쉽지 않다. 근데, UI/UX 담당팀, 세일즈 팀 같은데를 가 보면 정반대다. 여성 인력이 상당하다. IT업계도 사업하는 회사기 때문에 여러 직군의 일이 다 있고, 아마존이 최소한의 합리성을 갖고 저 AI Recruiter라는 걸 만들었다면 당연히 직군별로 다른 값을 넣거나, 다른 모델을 썼을 것이다.

IT업계에 남성 인력이 압도적으로 많기 때문에 남성 위주의 알고리즘이 만들어졌을 것이라는 주장이 맞으려면 팀 구분없이, 개발자들만 왕창있는 회사들 기준으로 모델이 만들어졌어야한다. 위에 링크를 건 Reuter 기사에 따르면 Amazon 전체로 보더라도 여성인력이 최소한 30%는 된다.

성차별적인 데이터를 입력했던 것이 아니라, 성별에 관계없이 문자열만 넣은 데이터에서 나온 결론이 하필이면 성차별적인 결론과 인과관계도 아니고 상관관계만 높았던 것에 불과하다.

나가며 – 모델링에 대한 잘못된 이해

한국에서 자연어처리 (NLP) 과정을 제대로 이해 못 하는 사람들이 저런 “Resume screener”를 만들었다면 어땠을까? 예전에 어느 인사팀에서 비슷한 일을 하는 걸 봤었는데, 인력의 신상명세에 해당하는 정보들을 전부 Column으로 만들어놨더라. 예를 들면 성별, 전공 종류, 학점, 입사 후 평가, 직급, 직책 등등의 정보들 몇년 치를 입력해놨었다. 아마 그 DB 만들었던 팀이 엄청나게 고생했을 것이다.

그렇게 구성한 데이터로 (Logistic) Regression 기반의 모델을 만들었다면 어떻게 되었을까?

성별 정보가 들어갔기 때문에 분명히 남, 여에 따라 결과값이 다르게 나왔을 때 모델의 성 차별적인 부분에 대한 지적이 가능할 것이다.

그런데, 위의 Amazon 모델은 단순하게 Resume에 쓴 단어들로 자연어처리만 했다. 영문 Resume 어디에도 성별을 구체적으로 써 놓거나, 심지어 짐작할 수도 없는데, 어떻게 남녀 차별적인 AI라고 할 수 있을까? 위에 언급했던대로 상관관계 (Correlation)가 있다는 이유로 인과관계 (Causation)가 있다는 결론을 내릴 수는 없다.

이 블로그에서 줄곧 이야기한대로, 저런 Resume screener가 “인공지능”이라고 생각하지는 않지만, 최소한 “남녀 차별적인”이라는 설명은 좀 억울한 설명일 것 같아 보인다.

어쩌다가 언론에 흘러나오게 되었는지, 또 무슨 이유로 더 이상 안 쓴다는 식으로 언론 플레이를 하고 있는지는 모르겠지만, 최소한 누명은 좀 벗겨 주고 싶었다. 데이터로 모델링하는 사람 입장에서 모델링 방식에 따라 충분히 편견을 배제한 모델링을 할 수 있는데, 너무 결과값만 놓고 상관관계와 인과관계를 혼동하며 누명을 씌우지는 말았으면 한다.

2019년 3월 6일 추가

윗 글이 Ruliweb이라는 커뮤니티에 “AI가 여성을 탈락시킨다”는 글에 대한 반박 댓글에 활용되었던 탓에 윗 포스팅 내용으로 여러가지 논의가 있었기에 간략하게 사족을 답니다.

Amazon에서 탈락시킨 여성 지원자 분들의 이력서에 Women’s 라는 단어가 사용된 경우에 감점되었거나 심지어는 탈락되었다는 기사 원문의 내용을 들며 남녀정보가 없었던게 아니라고 반박하셨던 댓글을 봤습니다. 시스템이 자연어 처리를 얼마나 복잡하게 했는지에 대해서 직접 모델링을 한 사람이 아닌 관계로 단정적으로 말할 수는 없지만, Women’s가 들어갔다는 이유로 그 지원자를 여성으로 분류한 다음, 여성이라는 정보를 인지한 상태에서 모델을 만든 것이 아니라, 단순히 Women’s 라는 단어가 나타난 경우에 탈락율이 높았다는 뜻에 불과하다는게 윗 글의 논지입니다.

반박하셨던 분의 댓글에 따르면, Women’s라는 단어가 들어가지 않았던 여성 지원자의 Resume를 여성으로 분류하는 Precision/Recall과 Women’s라는 단어가 들어갔던 여성 지원자 Resume를 여성으로 분류하는 Precision/Recall을 봐야할텐데, 애시당초 그런 작업없이 단순히 단어 조합으로 합/불을 결정하는 분류 모델이 돌아갔었을 것이라고 생각해서 위의 글을 썼습니다.

부족한 블로그 글을 사회문제를 논의하실 때 활용해주셔서 감사드립니다. (죄XXX님, Mfxxx님 감사드립니다)